Nvidia on Mo今天推出了H200,这是一款图形处理单元,旨在培训和部署各种人工智能模型,为生成式人工智能热潮提供动力。

H200包括141GB的下一代“HBM3”内存,将帮助它使用人工智能模型生成文本、图像或预测。

对英伟达AI gpu的兴趣推动了该公司的发展,预计本季度销售额将飙升170%。

英伟达(Nvidia)周一发布了H200,这是一款图形处理单元,旨在训练和部署推动生成式人工智能热潮的各种人工智能模型。

这款新GPU是OpenAI用于训练其最先进的大型语言模型GPT-4的H100芯片的升级版。大公司、初创公司和政府机构都在争夺有限的芯片供应。

据雷蒙德·詹姆斯公司(Raymond James)估计,H100芯片的成本在2.5万美元到4万美元之间,在一个被称为“训练”的过程中,需要数千个芯片一起工作,才能制造出最大的模型。

对英伟达AI gpu的兴奋推动了该公司的股价,到目前为止,该公司股价在2023年上涨了230%以上。英伟达预计第三财季收入约为160亿美元,同比增长170%。

H200的关键改进在于它包含了141GB的下一代“HBM3”内存,这将有助于芯片进行“推理”,或者在训练后使用大型模型来生成文本、图像或预测。

英伟达表示,H200的输出速度将是H100的近两倍。这是基于使用meta的Llama 2 LLM的测试。

H200预计将于2024年第二季度上市,将与AMD的MI300X GPU竞争。与H200类似,AMD的芯片比其前身拥有更多的内存,这有助于在硬件上安装大型模型来运行推理。

英伟达表示,H200将与H100兼容,这意味着已经在使用之前型号进行培训的人工智能公司不需要改变他们的服务器系统或软件来使用新版本。

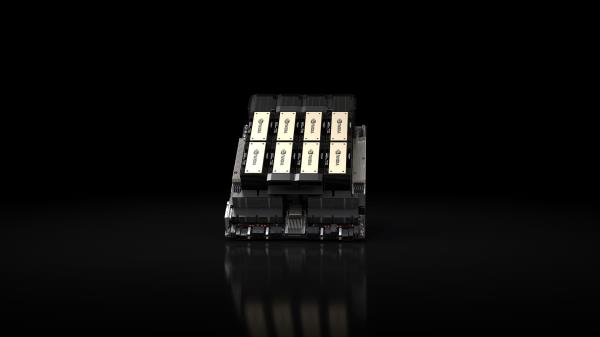

英伟达表示,它将在该公司的HGX完整系统上提供四GPU或八GPU服务器配置,以及一款名为GH200的芯片,该芯片将H200 GPU与基于arm的处理器配对。

然而,H200可能不会长期占据英伟达最快AI芯片的桂冠。

虽然像英伟达这样的公司提供了许多不同的芯片配置,但新的半导体通常每两年就会向前迈出一大步,因为制造商会转向一种不同的架构,这种架构比增加内存或其他较小的优化能带来更显著的性能提升。H100和H200都基于英伟达的Hopper架构。

今年10月,英伟达告诉投资者,由于对其gpu的高需求,它将从两年的架构周期转变为一年的发布周期。该公司展示了一张幻灯片,暗示它将在2024年宣布并发布基于即将推出的Blackwell架构的B100芯片。